专家解读:Web安全原理与技术分析(下)

4、Web木马检查工具:

Web安全不仅是维护网站自己安全,通过网站入侵用户电脑的危害也十分棘手。网页容易被挂上木马,或被XSS攻击利用,是否有工具可以对所有的网页进行安全检查呢?这里用到了“爬虫”技术。

“爬虫”技术最早是搜索引擎“发明”的,搜索网站放出N个小“爬虫”,在世界各地的网站上循环扫描,收集网站上的新信息,建立供世界人民查找的数据库,这样大家就可以从Google、百度等搜索门户上搜到你想要的任何东东。由于“爬虫”来自网站外部,所以可以模拟用户打开网站的实际效果,所以“爬虫”很快被网站用来测试自身性能的“用户体验”工具,比如网页打开的速度,用户互动的等待时间等。作为用户体验工具,“爬虫”很快也在企业内部网络上开始流行,关注用户感受,是08年开始IT领域内最流行的开发理念。

所谓“爬虫”就是这样一些进程,按照一定的规则(横向优先搜索、纵向优先搜索),将网站上所有的页面打开一遍,(你知道很多网站的点击率飞涨的原因了吧,是有无数的小爬虫在工作…),在对网页上关心的事情进行检查。由于是以用户的身份“浏览”网页,所以没有静态与动态页面的差别。Web木马检查工具就是基于这个原理开发的,不同于搜索爬虫的是,在网页检查时,重点查看网页是否被挂木马,或被XSS利用。因为网站内的URL链接去向应该可追溯的,所以对XSS的检查是很有效的。(“爬虫”有些象网页防篡改的文件检查进程是吧,不过一个是在Web服务器的内部,另一个是在web服务器的外部)

Web木马检查工具一般作为安全服务检查使用,也可以单独部署一台服务器,定期对网站检查,发现问题及时报警。该工具目前市场上的产品化很少,一般不销售,网上有些免费的类似软件可以试用,随着Web服务在企业内的应用增多,该工具应该象防病毒检查工具一样流行。

五、新的想法---主机Web网关

Web服务是从互联网技术发展起来,互联网是“草根”文化的集大成者。在互联网中,共享智慧是追求,简捷实用是方法。

很常见的现象,Web服务的处理能力采用集群技术、云计算技术,都是利用物美价廉的PC服务器集成在一起,而不是选用“庞大”的巨型机。P2P技术、CDN技术都是网民降低Web服务中心压力,而又能支持大用户、实时流媒体业务的“互联网Web技术”。但这也为Web业务的安全防护带来问题---网络结构问题。为了提供处理能力,众多的服务器“网”一样地接在核心交换机上,在服务器前没有汇聚点,web防火墙的部署就成了问题。

草根文化的特点就是系统避免过渡依赖某一个点(大家都是重要的)。Web服务不同于传统银行模式的集中处理,服务器是PCServer组成的群,由于加入与离开群,对群的服务没有影响,只是服务处理能力的动态变化而已,所以服务器群中的每个服务器的处理能力相对不是那么宝贵,某个服务器的异常宕机也只是对个别的用户服务有些“临时影响”,在服务器中安装Agent的“恐惧”,Web服务管理者应该是没有的。

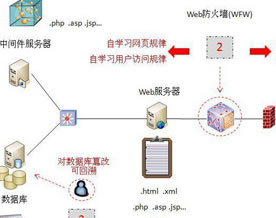

为了与“群”或“云”等Web新型网状结构相适应,Web服务应用层的防护,可以与网页防篡改合起来(尤其是OS提供底层的文件修改监控),我们给它一个新的名字---主机Web网关(Host Web Gateway)。

主机Web网关的部署与防篡改产品一样,以Agent的形式嵌入到Web服务器中,不需要再关心Web服务的网络结构,同时,也避免了在Web服务使用加密协议时,网关安全设备对应用层攻击无能为力的弊端。

主机Web网关的主要功能:

◆Web应用入侵防护(SQL注入、XSS等)

◆页面文件防篡改

◆Web网页自动学习功能

◆Web用户访问行为的自学习功能

至于系统级的入侵防护与DDOS防护,放在UTM/IPS中解决,Web服务的网络结构就灵活多了。主机Web网关采用软件形式,没有了串行设备的性能要求,部署的成本也会大大下降。